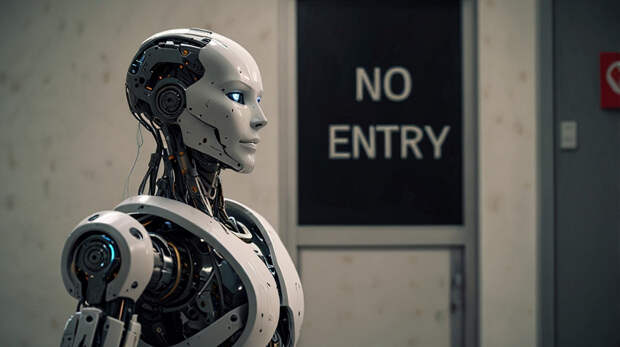

Исследователи Массачусетского технологического института (MIT) выявили критический недостаток в популярных моделях, связывающих обработку изображений с текстом (VLM — Vision-Language Models). Эти системы, используемые в медицине для анализа снимков, некорректно интерпретируют слова отрицания, такие как «нет» или «не».

Например, при поиске рентгеновских изображений с отёком тканей, но без увеличения сердца, модель может предложить случаи, где оба признака присутствуют. Это чревато ошибками в диагностике: сочетание отёка и увеличенного сердца указывает на сердечное заболевание, а их разделение — на другие причины. Кумайл Альхамуд, аспирант MIT и ведущий автор работы, отметил: «Игнорирование отрицаний может привести к катастрофическим последствиям, если модели внедряются без проверки».

Для решения проблемы учёные создали специальный набор данных с 10 миллионами пар «изображение-подпись», включающих отрицания. После переобучения на этих данных точность моделей …

Свежие комментарии